Arquivos de Impressão: Tamanho A4 (pdf), Tamanho A5 (pdf), Texto (txt).

Nós iniciamos este artigo com a definição de entropia e informação, na física e engenharia, usando os conceitos de estado e de símbolo, baseados na teoria da probabilidade aplicada no espaço e no tempo respectivamente. A quantidade de informação e o nível de organização é proposto como a principal característica da vida. É calculada a quantidade de informação do código genético e o resultado é comparado com as dimensões do tempo e espaço do universo estimados pela ciência humana. Baseado nestas idéias, nós definimos um sinal total como uma função de um sinal determinístico mecânico e um sinal probabilístico vital. É proposto um sistema chamado AnaSin que realiza uma Análise matemática no lado emissor de um canal de comunicação e uma Síntese no lado do receptor. Nós apresentamos a hipótese de que a atividade eletro-química dos neurônios de nosso cérebro é uma espécie de símbolo da realidade exterior mensurando a quantidade de informação. Nós apresentamos a hipótese de que as leis probabilísticas da física quântica talvez sejam um sinal da presença espiritual viva no interior dos átomos. Nós concluímos que a teoria da informação, nascida na engenharia, pode fazer uma conexão entre a física e a biologia.

Este trabalho foi atualizado em 2012, quando nos beneficiamos com o conhecimento da ciência revelada no:

"Livro de Urantia", parágrafo 58.2_3: E, ainda assim, alguns dos menos imaginativos entre os vossos mecanicistas mortais insistem em ver a criação material e a evolução humana como um acaso. Os seres intermediários de Urantia reuniram cerca de cinquenta mil fatos da física e da química que eles julgam ser incompatíveis com as leis das probabilidades do acaso, os quais, segundo eles defendem, demonstram inequivocamente a presença de propósito inteligente na criação material. E tudo isso não leva em conta o seu catálogo das mais de cem mil descobertas, fora do domínio da física e da química, que eles sustentam serem uma prova da presença da mente no planejamento, criação e manutenção do cosmo material.

A teoria da probabilidade, unida ao conceito de estados, deu nascimento à física estatística [1] e a definição de entropia. Entropia é uma função do número de estados igualmente prováveis de um sistema físico. Para contar o número de estados possíveis de um sistema físico nós utilizamos uma ferramenta matemática da teoria da probabilidade chamada análise combinatória. Suponha por exemplo que nós tenhamos um sistema de dois magnetos e que cada um deles possa ser orientado para cima ou para baixo. Qual é o número de estados de orientações possíveis destes 2 magnetos? O número n2 de estados possíveis é 2 possibilidades do primeiro magneto vezes 2 possibilidades do segundo, matematicamente:

| (1) |

Suponha agora que nós tenhamos outro sistema físico similar com 3 magnetos, neste caso o número n3 de estados possíveis é:

| (2) |

Agora suponha que nós unamos os dois sistemas acima e formemos um novo com um total de 5 magnetos. Neste caso n5 é dado por:

| (3) |

Nós dissemos que a entropia é uma função do número de estados de um sistema. A função escolhida é o logarítimo. Entropia é o logarítimo do número de estados igualmente prováveis de um sistema físico. Um dos motivos para esta escolha é que nós desejamos que a entropia de um sistema, feito pela união de dois outros, seja a soma da entropia deles. E de fato a entropia do sistema acima, com 5 magnetos, constituído pela união de dois outros compostos por 2 e 3 magnetos é dada por:

|

Como nós podemos ver o membro mais a direita desta equação é a soma da entropia de um sistema de 2 e 3 magnetos respectivamente. Em conclusão, a definição matemática da entropia de um sistema físico com um certo número de possíveis estados igualmente prováveis é:

entropia = logarítimo (número de estados)

A quantidade de informação que pode ser armazenada na memória de um computador digital com um certo número de estados igualmente prováveis é:

informação = logarítimo (número de estados)

A memória de nossos computadores digitais é composta por elementos que podem estar em um dentre dois estados. Estes elementos bi-estados são chamados de digitos binários [binary digits] ou abreviadamente bits. Se nós tivermos 8 digitos binários juntos, cada um com dois estados possíveis, o número total n8 de estados deste sistema de 8 bits é:

| (5) |

Para obtermos uma maior simplicidade numérica, nós escolhemos a base logarítimica 2 para calcular, com precisão, a quantidade de informação na engenharia de computadores digitais binários. Assim um sistema com 8 digitos binários com estados igualmente prováveis é capaz de armazenar uma certa quantidade de informação dada por:

| (6) |

A probabilidade do evento de um estado em um sistema capaz de um dado número "n" de estados possíveis igualmente prováveis é dada por:

| (7) |

Isto implica neste caso, de estados igualmente prováveis, que:

|

Em seu memorável artigo, Shannon [2], o pai da teoria da informação, analisou a quantidade de informação que nós podemos transmitir em um canal de comunicação em uma certa condição de ruído. Ele associou cada possível estado de um canal de comunicação com um símbolo de um alfabeto. Neste caso prático o evento de um estado ou símbolo pode ocorrer com probabilidades diferentes. Assim com estados e símbolos que não são igualmente prováveis a informação "I" transmitida por um símbolo de probabilidade "P" de ocorrência é dada por:

| (9) |

Informação é o logarítimo do inverso da probabilidade de um símbolo. Este símbolo pode ser um estado de memória de um computador localizado no espaço. Este símbolo pode ser um evento em um canal de comunicação que acontece em um momento do tempo. Símbolo, estado, espaço. Símbolo, evento, tempo. Através da generalização do conceito de símbolo nós vamos generalizar o conceito de informação e sua teoria na seção 8.

Os estados e os movimentos dos organismos vivos tem uma pequena probabilidade de acontecer naturalmente na matéria morta e consequentemente estes estados tem uma alta quantidade de informação. É muito pequena a probabilidade de que um organismo seja feito repentinamente por átomos de matéria morta que se unam em uma região do espaço formando moléculas, tecidos, orgãos e o corpo inteiro deste organismo. De acordo com as leis físicas é muito pequena a probabilidade de que todos os átomos de alguns kilogramas de matéria, repentinamente se movam para cima na direção contrária a força da gravidade. Contudo este movimento improvável acontece quando uma mãe eleva sua pequena criança em seus braços. De acordo com as leis físicas, o estado de organização e os movimentos surpreendentes da vida são altamente improváveis de acontecer expontaneamente na matéria morta. Uma pequena probabilidade implica em grande quantidade de informação porque:

|

As palavras orgão e organismo possuem a mesma origem semântica que organização. Os corpos dos organismos vivos estão em um estado de elevado nível de organização. Este estado tem pequena probabilidade de acontecer na matéria morta e devido a isso a quantidade de informação do sistema é grande. Também os engenhos feitos pelo ser humano são um sinal da presença de vida e de um organizador inteligente. Existe uma pequena probabilidade que os átomos da matéria morta repentinamente formem uma casa, um carro, um computador e outros engenhos humanos. Devido a pequena probabilidade de que estes engenhos apareçam sem um criador, estes sistemas físicos estão também em um estado de alto nível de organização e de quantidade de informação.

Devido a estes fatos nós estamos apresentando neste artigo a quantidade de informação, no estado e movimentos de um sistema, como uma medida científica da presença de vida. Se nós olharmos, a análise energética e química de um sistema físico, não poderemos ter certeza que este sistema está vivo ou morto. Energia, massa e outras quantidades das teorias físicas são mais aplicáveis ao estudo de corpos mortos. É importante também mencionar que a informação é uma quantidade sem dimensões físicas. Isto é assim devido a duas causas matemáticas: 1 - a frequência de um estado ou evento, necessária para calcular a probabilidade, é um número puro; 2 - a função logarítimica do inverso da probabilidade, necessária para calcular a quantidade de informação, tem a propriedade de transformar as quantidades físicas em grandezas adimensionais.

Como uma consequência prática vamos analisar o nível de organização e a quantidade de informação nos vírus e cristais, que são sistemas nos limites entre os reinos dos vivos e dos mortos. Alguns biólogos nem ao menos consideram os vírus como um ser vivo porque eles não apresentam muitas das características de outros organismos. Os vírus consistem apenas de uma molécula genética envolvida por uma "capa proteíca". Eles não se movem ou crescem por si mesmo. Eles não possuem metabolismo energético ou químico. Eles se reproduzem usando a estrutura de outras células vivas. E eles podem ser cristalizados como pedras e permanecer os mesmos por milhares de anos. Então qual é a única característica da vida nos vírus? É o nível de organização e a grande quantidade de informação no seu código genético. Devido a isso nós vamos afirmar que a informação carregada no estado da matéria dos vírus é uma das únicas marcas da vida em seu micro sistema. Do outro lado, no reino dos mortos, os cristais são uma das substâncias materiais com maior nível de organização. Este nível de organização, e consequentemente grande quantidade de informação, implica que os cristais tem mais da "marca da vida" do que outras substâncias mortas. E de fato, cada cristal tem uma forma característica que multiplica a si mesma quando colocada em um substrato amorfo adequado. Nós até dizemos que os cristais são sementes que plantamos e que crescem em um substrato. Assim os cristais, a substância morta com maior quantidade de informação, tem uma espécie de característica reprodutiva que é como uma propriedade da vida. Este é mais um fato a favor da idéia de que a quantidade de informação é a principal "marca da vida".

A quantidade de informação cresce com o inverso da probabilidade de um estado em uma região do espaço, e de um evento no tempo. Se nós analizarmos a probabilidade de um estado de matéria localizada em uma região do espaço, em geral quando calcularmos uma grande quantidade de informação nós iremos descobrir a posição de um organismo vivo. O estado de organização dos corpos vivos é inprovável na matéria morta e, devido a isso, cheio de informação. Na seção 5 nós vamos calcular a quantidade de informação no genoma humano. Por outro lado, se nós computarmos a probabilidade de um evento ou movimento no tempo, nós também podemos detectar a presença de vida. Os corpos mortos se movem de uma forma mais predizível do que os organismos vivos. Os movimentos surprendentes da vida são cheios de informação. Nós vamos ver na seção 6 que a única informação de uma cena em movimento são os sinais vitais que vem da vida. Movimentos mecânicos de um corpo morto, determinados plenamente por uma equação matemática, não carregam nenhuma informação nova. Este fato vai ser usado na seção 7 para propor um sistema de comunicação capaz de achar e transmitir a única informação real de uma cena em movimento, que são os sinais vitais.

Nós vamos calcular o número de combinações possíveis do nosso código genético. De acordo com a ciência o genoma humano tem cerca de 3 bilhões de bases nucléicas. Cada uma destas bases pode ser um, dentre quatro tipos, na sequência genética. Isto resulta em um número "N" de possíveis combinações de:

| (11) |

Este número tem mais de um bilhão de caracteres. Somente para escrevê-lo, nós preencheríamos mais de 400.000 páginas com 2.500 caracteres em cada uma delas. Estas páginas seriam suficientes para formar 4.000 livros de 100 páginas cada um. Isto poderia preencher 100 prateleiras com 40 livros em cada uma. Estas prateleiras poderiam compor 10 estantes, com 10 prateleiras em cada uma, preenchendo uma pequena biblioteca com os livros necessários somente para escrever este enorme número em notação decimal. Em uma condição na qual todos estes possíveis códigos genéticos sejam igualmente prováveis, a probabilidade "P" de sortear a combinação única, de nosso genoma, entre todas as possibilidades é:

| (12) |

Esta pequena probabilidade e grande sorte contêm a quantidade de informação "I" dada por:

| (13) |

Agora vamos calcular o número de possíveis códigos genéticos que nós teríamos se desde o início do universo, nós escolhessemos a cada segundo combinações genéticas novas, de uma substância com um mol de genomas humanos por litro, preenchendo todo volume presente do universo conhecido. É estimado que a idade do universo é alguma coisa na ordem de 10 bilhões de anos. Este tempo em segundos resultaria em um período de:

| (14) |

Multiplicando este tempo pela velocidade da luz, e calculando o volume da esfera assim formada, nós teremos uma estimativa do volume do universo de:

| (15) |

Agora imagine que cada litro deste volume total esteja preenchido por um mol de genomas humano. Um mol desta substância irá ter 6 ·1023 códigos genéticos. Suponha que desde o início do universo, em cada segundo, cada genoma humano, da substância descrita acima, preenchendo todo volume do universo, "tentasse" uma nova combinação. Qual o número total "n" de combinações formadas desta maneira?

|

Este número de combinações seria suficiente para com sorte alcançar a sequência correta de uma cadeia genética com somente 204 bases nucléicas. Mas isso é aproximadamente o tamanho do menor gene do genoma humano. O fato é que, mesmo se nós considerássemos a seleção natural e a reprodução combinada, o número total de combinações possíveis dos 3 bilhões de bases nucleotídicas do genoma humano, é de longe muito maior que o número de combinações que podem ser "tentadas" em todo volume do universo desde o seu começo, na forma calculada acima. A conclusão óbvia é que: o genoma humano é tão organizado e cheio de informação, que seria praticamente impossível que ele tenha vindo da matéria morta caótica.

A teoria criacionista propõe que Deus criou a vida. A teoria evolucionária afirma que a vida evoluiu da matéria morta pelo acaso e pela seleção natural. Acabamos de calcular as probabilidades do genoma humano evoluir, até o seu presente estado, em consequência de mutações ao acaso, e da seleção natural dos organismos mais adaptados. Lembramos que a palavra probabilidade vem de probe, em inglês, que significa prova. Probabilidade é sinônimo de provabilidade. Provamos com alguns cálculos probabilísticos que é impossível que a vida humana tenha surgido da matéria morta somente devido ao acaso. Provamos que mesmo que todo volume presente do universo fosse preenchido por um mol de genoma humano em cada litro, fazendo uma tentativa de um novo código genético a cada segundo, mesmo assim a probabilidade de acerto seria de somente um gen com 204 nucleotídeos. Logo, basta um mínimo de análise combinatória para verificar que é improvável, talvez impossível, que os 3 bilhões de nucleotídeos do genoma humano tenham evoluído, da matéria morta, através da seleção natural de mutações ao acaso. Seria improvável que surgisse a mutação correta. Sem o genoma correto não haveria material para ser selecionado naturalmente.

A teoria evolucionária incompleta pode ser integralizada pela teoria criacionista. É revelado que aparecem subitamente novas ordens de vida. É nestas transformações súbitas e decisivas que o criador se manifesta na vida criada. Como exposto na ciência revelada do:

"Livro de Urantia", parágrafos 58.6_2-3: Ainda que a evolução da vida vegetal em vida animal possa ser determinada, e embora hajam sido encontradas séries graduais de plantas e animais que progressivamente se desenvolveram dos mais simples aos mais complexos e avançados organismos, vós não sereis capazes de encontrar esses elos de ligação entre as grandes divisões do reino animal, nem entre o mais elevado dos tipos de animais pré-humanos e o alvorecer dos homens das raças humanas. Esses chamados "elos perdidos" permanecerão para sempre perdidos, pela simples razão de nunca haverem existido.

De era para era, aparecem espécies radicalmente novas de vida animal. Elas não evoluem como consequência da acumulação gradual de pequenas variações; surgem como novas ordens de vida, plenamente desenvolvidas, e aparecem subitamente.

Esta breve análise é amplamente explicada no livro "Universo Inteligente" [5], onde são examinadas as chances do organismo humano ter surgido ao acaso. Ken Wilber apresenta uma outra grave falha da teoria da evolução, ao acaso, da matéria morta até os organismos vivos. Considere a formação de uma asa. Não basta meia asa para se voar. Meia asa seria uma desvantagem diante da seleção natural. É preciso uma mutação súbita e inteira para gerar duas asas funcionais e um pássaro selecionável pelo ambiente natural. Os aparecimentos súbitos, de novas ordens de seres vivos, sugerem a participação decisiva do criador da vida no lento processo de evolução natural. Nestas mutações súbitas e criativas podemos observar a tese da teoria criacionista na geração de criaturas mais adaptadas que podem ser selecionadas naturalmente conforme a tese da teoria evolucionária.

"Livro de Urantia", parágrafo 60.3_22: Há 55 milhões de anos, a marcha evolucionária foi marcada pelo aparecimento súbito dos primeiros pássaros verdadeiros; uma pequena criatura semelhante a um pombo foi o ancestral de toda a vida avícola. Esse foi o terceiro tipo de criatura voadora a aparecer na Terra, e originou-se diretamente do grupo dos répteis; não veio dos dinossauros voadores dessa época, nem dos tipos anteriores de pássaros terrestres com dentes. E, assim, essa se tornou conhecida como a idade dos pássaros, bem como a do declínio dos répteis.

Da mesma forma, foram necessárias três mutações sucessivas dos lêmures primitivos para que surgisse o primeiro casal com uma mente com dignidade de vontade do tipo humano.

"Livro de Urantia", Capítulo 62: HÁ CERCA de um milhão de anos os ancestrais imediatos da humanidade fizeram o seu aparecimento por intermédio de três mutações sucessivas e súbitas, descendendo da raça primitiva do tipo lemuriano de mamíferos placentários. Os fatores dominantes desses lêmures primitivos derivavam do grupo ocidental, ou americano tardio, do plasma da vida evolutiva. Antes, porém, de estabelecer a linha direta de ancestralidade humana, essa descendência foi reforçada por contribuições da implantação central de vida evoluída na África. O grupo de vida oriental contribuiu pouco, ou de fato nada, para a verdadeira produção da espécie humana.

Na seção anterior nós analisamos a informação calculada baseada na probabilidade do estado combinatório do nosso código genético. A probabilidade de organização de um estado no espaço é usada para calcular a entropia de um sistema na física estatística. Na engenharia, a probabilidade de um evento no tempo é usada para calcular a quantidade de informação em um canal de comunicação. A grande quantidade de informação nos organismos vivos aparece, não apenas no seu estado de grande organização no espaço, mas também nos seus surpreendentes movimentos livres no tempo. Nós vamos provar nesta seção que quase toda a informação de um sistema em movimento está nos movimentos da vida que iremos chamar de sinais vitais. Desta prova nós iremos propor na próxima seção um sistema prático de comunicação de informação.

Nós vamos chamar de sinal total a qualquer sinal transmissível. O sinal total é uma função de um sinal determinístico e um sinal vital. O sinal determinístico é a parte, do sinal total, com seus valores futuros totalmente determinados por uma equação matemática. O sinal vital é a parte informativa restante. Em linguagem matemática:

| (17) |

Nós afirmamos, que a informação do sinal total está no sinal vital, porque o sinal vital é a única parte do total que é surpreendente, inpredizível, probabilística e estocástica. Os valores futuros do sinal determinístico são, por definição, totalmente determinados por uma equação matemática. Assim a probabilidade de receber um determinado valor de um sinal determinístico é sempre "1". Se a probabilidade de um valor determinado é "1" a informação que ele contém é "0" pois:

|

Existe uma outra maneira de provar que é zero, a informação transmitida em um sinal determinístico matematicamente previsível. Suponha que nós queiramos transmitir um sinal de vídeo dos movimentos do sol e dos planetas de nosso sistema solar. Também, suponha que estes movimentos obedeçam com precisão as equações físicas da mecânica clássica [3]. Além disso, imagine que nós transmitimos através do canal de comunicação, em um intervalo de tempo finito, as equações e os valores iniciais do movimento. Finalmente suponha que o lado receptor, com esta informação sobre as posições iniciais e velocidades destes corpos astronômicos e com o conhecimento das equações que descrevem seus movimentos, calcule todas as posições futuras e reconstrua o sinal de vídeo para um tempo infinito. Se houvesse qualquer informação em um intervalo de duração finita, do sinal de vídeo acima descrito, seria possível transmir uma quantidade de informação infinita em um intervalo de tempo finito. A informação infinita do vídeo reconstruído por um tempo infinito teria sido transmitida no intervalo de tempo finito necessário para transmitir o estado inicial das equações de movimento do sinal de vídeo. O mesmo paradoxo acontece com todos os sinais determinados, porque nós podemos transmitir os parâmetros e equações em um intervalo de tempo finito e o lado receptor pode determinar os valores futuros de todo o tempo infinito adiante. A solução óbvia para este paradoxo é concluir que a informação em um sinal determinístico é "0" para um intervalo de tempo finito e infinito.

A parte essencial e vital de um sinal é a única informação do total. Por definição o sinal vital é a parte do total que não pode ser determinada exatamente por uma equação matemática. Sinais vitais são sinais probabilísticos. Nós escolhemos o termo vital porque em geral os movimentos da vida são uma parte de um sinal que nós não podemos colocar em uma equação matemática exata e determinística. É importante lembrar que um sistema complexo também pode gerar sinais probabilísticos. E nós iremos lembrar também na seção 9 que as leis da física quântica são probabilísticas. Nós mencionamos também que em um certo sentido uma equação matemática determinística é um caso particular dos casos probabilísticos, o caso no qual a probabilidade é um.

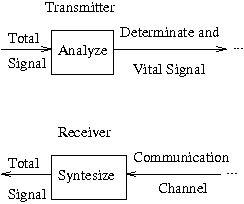

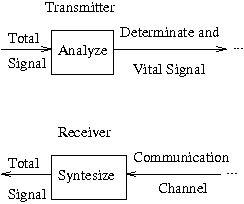

A última seção estabeleceu as bases teóricas de um sistema de comunicação chamado anasin. Na engenharia de comunicações, MoDem Modula e Demodula, CoDec Codifica e Decodifica e AnaSin irá Analizar e Sintetizar um sinal, respectivamente, no lado emissor e receptor de um canal de comunicação. No lado emissor anasin irá analisar e separar a parte determinística da parte vital do sinal total. A análise matemática vai também fornecer a descrição matemática da parte determinística. Extraíndo a parte determinística, do sinal total, restará a parte vital. O outro lado do canal de comunicação recebe as equações e parâmetros do sinal determinístico e vital. Então o anasin sintetiza a parte determinística e calcula o sinal total como uma função da parte vital. Este sistema de comunicação é mostrado no diagrama 7:

Obviamente a análise do sinal não é apenas matemática, mas também física. O conhecimento, sobre a fonte física, o ambiente de transmissão e o instrumento de medida do sinal, é importante para definição do tipo de equação que devemos procurar em nossas análises. Por exemplo, se nós temos um sinal de vídeo, a parte determinística terá um modelo tridimensional, do ambiente e dos objetos da cena, regido de acordo com as leis da geometria euclidiana e da física clássica. A parte vital do sinal serão os movimentos realizados pelos seres vivos da cena. Existe um jogo famoso na Internet chamado: "Quake", que realiza este procedimento em um certo sentido. "Quake" é uma luta que ocorre em diferentes ambientes arquitetônicos, cada jogador é um soldado que se move e vê outros participantes se movendo também. Os movimentos ocorrem de uma forma rápida e surpreendente até mesmo na baixa velocidade da antiga Internet. Para alcançar esta rapidez, a geometria de todos os ambientes, o número, forma e uniformes de todos os jogadores, são conhecidos em cada lado antes do jogo começar. Em outras palavras: a parte determinística, do sinal de vídeo do jogo, é conhecida antecipadamente. Assim, somente é transmitido os movimentos dos jogadores vivos. Este movimentos dos jogadores são a parte vital do sinal total, a parte que contêm informação nova e é transmitida assim que chega. Suponha agora que estejamos transmitindo, através da Internet, a fala de uma pessoa em um webfone. Nós podemos imaginar que primeiramente o sistema anasin captura as características pessoais da voz de cada falante. Estas equações e parâmetros não variáveis dos falantes são a parte determinística do sinal de fala que é transmitida antes da conversação iniciar. Neste caso, a parte vital poderá ser composta pelos caracteres e palavras reconhecidas, e pela entonação dos falantes.

Nós sabemos que esta análise matemática e física não é trivial. Mas em teoria nós sabemos que existem leis físicas que descrevem uma grande extensão dos movimentos dos corpos e sistemas mortos. Sabemos também que os movimentos dos organismos vivos são uma parte da realidade física muito complexa para ser descrita por equações matemáticas exatas. Obviamente existem também movimentos de sistemas físicos muito complexos como as ondas do oceano e as nuvens do céu. Vão haver casos nos quais não será clara a separação entre os sinais determinístico e probabilístico. Existe também o ruído e as limitações dos nossos instrumentos de medida. Todos estes são problemas em aberto desta incipiente teoria da informação dos sinais vitais.

Para concluir está seção vamos dar um exemplo de um anasin. Suponha que nós desejemos transmitir um sinal de vídeo de um monitor de computador com uma imagem de fundo estática constituída por um degradê azul de baixo para cima e dos movimentos dinâmicos, de um cursor, controlados por um mouse. A imagem do fundo é o sinal determinístico e os movimentos do cursor é a parte vital conectada a mão do usuário do computador. O anasin irá primeiro transmitir a equação que descreve o fundo. O sinal determinístico é dado neste caso por:

| (19) |

Aonde a "luzazul" é a intensidade de 0 a 1 da parte azul de um pixel tricromático da imagem de fundo do monitor. A coordenada vertical do pixel é a "altura" e o valor máximo da "altura", no topo da tela em um sistema cartesiano, é a "alturamáx". Transmitida esta equação da imagem de fundo, nós precisamos agora somente transmitir as posições futuras do cursor, no monitor do computador, para reconstruir o vídeo do sistema. As posições variáveis do cursor são a parte vital do sinal de imagem total. Com o sistema anasin descrito acima a taxa de bits para serem transmitidos será somente a necessária para inicialmente transmitir os descritores da equação da imagem de fundo, e posteriormente menos de 23 bits para transmitir uma coordenada cartesiana do cursor toda vez que ele se mover. Se nós desejarmos transmitir este vídeo, sem nem um tipo de codificação, a uma taxa de 20 imagens por segundo, em um monitor de 800x600 pixels tricromáticos de 24 bits cada um, vamos precisar de 20 ×800 ×600 ×24 = 230.400.000 bits por segundo para transmitir este vídeo. Isto significa que neste caso com o anasin nós chegamos a uma taxa de compressão de mais de 10.000.000 por 1.

Nesta seção nós apresentamos a hipótese de que a atividade eletro-química dos neurônios de nosso cérebro são uma espécie de símbolo da realidade exterior mensurando sua quantidade de informação. A adaptação e a lei logarítimica, de nossos neurônios sensoriais, sugere que nós mensuramos a informação da realidade exterior com nossos sentidos. Nós mostramos por um exemplo que a natureza física de um símbolo não é essencial para sua função. Assim, a atividade eletro-química de nosso sistema nervoso pode ser também uma espécie de símbolo dos objetos da realidade exterior. Com esta generalização do conceito de símbolo nós amplificamos o conceito de espaço e tempo e finalmente de informação. Baseado nisso, a frequência de pulsos eletro-químicos em um neurônio seria a frequência de ocorrência de um símbolo dos eventos passados na região de seus dendritos e de eventos futuros na região de suas sinapses. A "força" das conexões entre os neurônios seria uma espécie de função do coeficiente de correlação e da probabilidade condicionada entre os símbolos representados por estes neurônios.

A adaptação e a lei logarítimica, de nossos neurônios sensoriais, sugere que nós mensuramos a informação da realidade exterior com nossos sentidos. A quantidade de informação cresce com as mudanças no tempo e no espaço. No nosso sistema nervoso, a adaptação e a inibição lateral aumenta a frequência, da atividade neuronal eletro-química, com as variações no tempo e espaço. Adaptação é a característica, da maioria de nossos neurônios sensoriais, de decrescer a frequência, de seus pulsos eletro-químicos, quando o estímulo físico estabiliza em certo nível. Quando um novo estímulo físico chega aos nossos sentidos, ocorre um aumento da frequência dos pulsos nos neurônios sensoriais. Se o estímulo persiste inalterado, a frequência decresce adaptando o sistema nervoso para a sua situação invariante. Devido a isso, nós adaptamos e acostumamos, com cheiros e estímulos táteis, sempre que persistimos no mesmo ambiente. Em outras palavras, a frequência dos pulsos eletro-químicos em nossos neurônios sensoriais aumenta quando ocorre um aumento da mudança no estímulo físico, e decresce quando não ocorre mudanças. Na retina do olho humano existe um circuito neurológico, chamado inibição lateral, que aumenta a frequência de pulsos dos neurônios quando ele detecta mudanças na intensidade de luz na região da retina. Cada neurônio sensorial da retina do olho está conectado à sua vizinhança através de conexões inibitórias. Este circuito, chamado inibição lateral, tem a propriedade de engrandecer a maioria das bordas de um objeto visual. Ele engrandece as regiões de mudança da intensidade da luz no espaço da retina. O olho é muito sensível às mudanças e movimentos no campo visual. Todos estes fatos provam a tese de que nossa percepção, assim como a quantidade de informação, cresce com as mudanças no tempo e no espaço.

É provado também, através de medidas experimentais, que a frequência dos pulsos eletro-químicos em nossos neurônios sensoriais é o logarítimo da intensidade do estímulo físico. Em experimentos cognitivos, sujeitos declaram que quando o estímulo físico é multiplicado pela mesma quantidade, eles percebem um mesmo aumento aditivo. Uma mudança geométrica transformada em uma mudança aritimética é também uma propriedade da função logarítimica como nós vimos na equação 4. O logarítimo é também a função que nós utilizamos para medir a quantidade de informação. De fato, quando nós queremos armazenar uma quantidade inteira, como uma informação na memória de um computador, nós utilizamos um número de bits de informação calculado como o logarítimo na base dois desta quantidade. O fato de que a função logarítimica esteja presente no nosso sistema nervoso sensorial sugere-nos que nós estamos mensurando informação com nossos sentidos.

A idéia, de que a nossa atividade neurológica é uma espécie de símbolo dos objetos exteriores, também contribui para tese de que nossa percepção mede a quantidade de informação da realidade exterior. Isto é assim, porque a informação é uma função da probabilidade de um símbolo. A primeira dificuldade desta tese é que a natureza física de nosso cérebro é completamente diferente do computador e dos símbolos de uma língua. Vamos analisar a importância dos constituintes físicos dos símbolos. Nós podemos simbolizar o mesmo objeto com símbolos de uma natureza física completamente diferente. O mesmo objeto pode ser simbolizado pelo desenho de uma palavra escrita, pelo som de uma palavra falada, pelas ondas eletromagnéticas de uma palavra difundida por uma estação de rádio e finalmente por relês, ou válvulas, ou transistores, ou discos ópticos, ou fitas magnéticas na memória de um computador. Isto sugere-nos que a natureza física, de um mesmo símbolo, pode ser muito diferente, talvez porque ela não seja importante para sua função simbólica. De fato, a informação é uma quantidade adimensional, sem dimensão física. Isto é assim porque a função logarítimica torna adimensional, as quantidades físicas. Também, a probabilidade de um símbolo é calculada com um número puro que é a frequência, no tempo ou no espaço, deste símbolo. Estes fatos motivam-nos a falar que um símbolo puro abstrato é algo que transcende o substrato físico, que uma informação é algo que transcende a forma física. Os símbolos e a informação são em certo sentido imateriais como as idéias.

Por outro lado, nós vamos afirmar que nossas idéias, percepções e em geral a atividade eletro-química de nosso sistema nervoso é uma espécie de símbolo dos objetos da realidade exterior. Esta é a hipótese chave de nossa generalização do conceito de símbolo e consequentemente da teoria da informação. Estas idéias nesceram com os computadores e sua analogia com o cérebro. Neste contexto, os símbolos tem a sua propriedade de existência relacionada com a existência do objeto simbolizado. Neste sentido a atividade eletro-química no nervo auditivo é um símbolo do som porque sua existência está relacionada com a existência do som na colchea de nossos ouvidos. E assim, a atividade eletro-química em nosso nervo óptico é um símbolo da luz porque sua existência está relacionada com a existência da luz na retina de nossos olhos. Em geral, nós podemos dizer que a atividade eletro-química, de nossos sentidos e neurônios aferentes, é um símbolo do estímulo físico exterior que causou esta atividade, porque a existência desta atividade é causada e relacionada com o estímulo físico. Também, nós podemos dizer que a atividade eletro-química de nossos neurônios motores e eferentes são um símbolo dos movimentos de nossos músculos, porque estes movimentos são causados e relacionados com esta atividade. A atividade de todo sistema nervoso é direta ou indiretamente relacionada com objetos da realidade. Esta atividade existe como causa, consequência, e algumas vezes simultaneamente e sempre em relação a objetos de diferentes naturezas físicas.

A quantidade de informação é o logarítimo do inverso da probabilidade de um símbolo generalizado em um espaço-tempo generalizado. Um espaço generalizado é um conjunto de possíveis símbolos de um sistema. Em um computador, os possíveis símbolos são os estados de sua memória. No cérebro, estes símbolos são a atividade eletro-química de seus neurônios. Um tempo generalizado é um "compasso" que marca os movimentos e mudanças dos símbolos variáveis de um sistema. Em um computador, o relógio de máquina marca as mudanças de seus símbolos. No cérebro, o tempo irá passar com as mudanças na frequência da atividade eletro-química dos neurônios simbolizantes mencionados acima. Mas se hipotetizarmos, que todas as categorias estão simbolizadas em nosso cérebro e a atividade deste é uma espécie de símbolo da realidade, o espaço físico e o tempo irão ser um caso particular do espaço-tempo generalizado acima, com um tipo especial de métrica e relações de continuidade entre os símbolos dos estados e seus movimentos.

Basicamente a atividade eletro-química de nossos neurônios consiste em pulsos de despolarização em suas membranas. No estado de repouso, devido ao transporte ativo de íons de sódio e potássio, existe uma diferença, na concentração de íons, entre o citoplasma e o ambiente extra-celular dos neurônios. Isto causa uma diferença de voltagem de -70 mili-volts entre o exterior e o interior da célula. Quando a diferença de potencial, através das membranas do corpo dos neurônios, ultrapassa determinado limite, alguns canais na membrana se abrem. Isto promove uma difusão de íons abrupta e a despolarização da membrana. Esta atividade eletro-química da membrana celular se propaga a partir do corpo do neurônio, através do seu axônio, chegando nas suas terminações sinápticas. O efeito global é que prolongações do corpo do neurônio, chamadas dendritos, realizam uma espécie de adição. Quando o somatório da voltagem atinge um certo limiar, pulsos de despolarização começam a se propagar ao longo do axônio do neurônio. A frequência destes pulsos aumenta como uma função da intensidade do estímulo. Como nós vimos anteriormente, a atividade eletro-química dos neurônios é uma espécie de símbolo de alguma coisa. Esta atividade é causada por estímulos na região dos dendritos e como consequência promove a atividade eletro-química nas suas terminações sinápticas. Devido a isso nós dizemos que a frequência dos pulsos eletro-químicos de um neurônio são a frequência de ocorrência de um símbolo de eventos passados na região de seus dendritos e de eventos futuros na região de suas sinapses.

Esta atividade eletro-química é transmitida de neurônio para neurônio através de conexões chamadas sinapses. Existem sinapses inibitórias e excitatórias. A atividade instantânea de um neurônio é mais fácil de se medir do que as modificações de suas conexões, porque estas modificações ocorrem lentamente. Contudo Kandell [4] provou a hipótese de Hebb, através da qual a força das conexões sinápticas aumenta se for simulânea a atividade eletro-química dos neurônios pós e pré sinápticos. É conhecido também que o número e o tamanho das conexões neuronais em pessoas idosas é maior que nas crianças. Isto sugere que a memória e a experiência aprendida é armazenada, ao menos em parte, nas conexões sinápticas. Além disso, experiências neurobiológicas mostram que se cortarmos um nervo em uma certa região, os neurônios anteriores morrem. Existem muitos experimentos mostrando como, a atividade eletro-química simultânea dos neurônios, influencia suas inter-conexões. A contribuição deste artigo é dar um significado probabilístico hipotético para as conexões entre neurônios. Porque nós acreditamos que a frequência dos pulsos eletro-químicos de um neurônio é a frequência de um símbolo, nós diremos que: a força das conexões entre neurônios é função do coeficiente de correlação e da probabilidade condicional entre os símbolos representados pela atividade eletro-química destes neurônios.

Estamos defendendo a idéia de que, em certo aspecto, a mente consiste em uma realidade de símbolos e informações, de signos e significados. Como veremos nas próximas citações, Claude Elwood Shannon, enumerou três motivos para mensurar a informação contida em uma mensagem simbólica, transmitida em um canal de comunicação, como sendo o logarítimo do número de mensagens do conjunto finito símbolos1 do qual foi selecionada a mensagem informativa que foi de fato comunicada. Estamos aqui sugerindo que a atividade eletro-química de um neurônio cristaliza a frequência de existência de um signo, um símbolo dos eventos causativos que provocaram esta atividade no corpo do neurônio e que comunica esta informação ao longo do "fio axonal transmissor" para os receptores pós-sinápticos deste neurônio em atividade. Reforçamos esta visão informacional, dos neurônios que compõe o sistema nervoso na base da mente, citando a chamada "lei de Fechner" que expressa a característica logaritimica do sistema nervoso sensorial.

Gustav Fechner percebeu que a sensação mental varia com o logarítmo do estímulo material (S = K log I). Ken Wilber2 citou Gustav Fechner ao escrever no início de seu livro [7]:

... Como um manual enfaticamente descreve:

"Na manhã de 22 de outubro - uma data importante na história da psicologia - Fechner teve a introvisão que o fez perceber que a lei da ligação entre mente e corpo pode ser encontrada num enunciado da relação quantitativa entre a sensação mental e o estímulo material."

A lei de Fechner, nome pelo qual ela passou a ser conhecida, é enunciada da seguinte forma: S = K log I (a sensação mental varia com o logarítmo do estímulo material).

Este fato matemático, sobre a ciência dos neurônios, sugere que o sistema nervoso sensorial mensura informações da realidade material exterior. Sugerimos isso baseado no fato de que a função logaritimica é também utilizada na teoria matemática da comunicação de informação através de um canal que liga o transmissor e o receptor de mensagens informativas. Como escrveu Claude E. Shannon [2]:

Uma Teoria Matemática da Comunicação Por C. E. SHANNON INTRODUÇÃO ... O problema fundamental da comunicação é o de reproduzir em um ponto, seja exatamente ou aproximadamente, uma mensagem selecionada em outro ponto. ... O aspecto significativo é que a mensagem de fato é uma única selecionada de um conjunto de possíveis mensagens. ...

Se o número de mensagens no conjuto é finito então este número, ou qualquer função monotônica deste número, pode ser considerado como uma medida da informação produzida quando uma mensagem é escolhida do conjunto, todas as escolhas sendo igualmente prováveis. Como foi indicado por Hartley a escolha mais natural é a função logaritimica. Embora esta definição deva ser generalizada consideravelmente quando nós consideramos a influência da estatística da mensagem e quando nós temos uma faixa contínua de mensagens, nós vamos em todos os casos usar uma medida essencialmente logaritimica.

A medida logaritimica é mais conveniente por várias razões:

- Ela é mais útil na prática. Parâmetros de importância na engenharia tais como tempo, largura de banda, número de relês, etc., tendem à variar linearmente com o logarítimo do número de possibilidades. Por exemplo, adicionar um relê3 à um grupo dobra o número de possíveis estados dos relês. Isto adiciona 1 ao logarítimo, na base 2, deste número. Dobrar o tempo aproximadamente eleva ao quadrado o número de possíveis mensagens, ou dobra o logarítimo, etc.

- Ela está próximo do nosso sentimento intuitivo da medida apropriada. Isto está intimamente relacionado com (1) desde que nós intuitivamente medimos as entidades por comparação linear com padrões comuns. O indivíduo sente, por exemplo, que dois cartões perfurados devem possuir duas vezes a capacidade de um para armazenar informação, e que dois canais idênticos tem duas vezes a capacidade de um para transmitir informação.

- Ela é matematicamente mais adequada. Muitas das operações limitantes são mais simples em termos do logarítimo mas irão requerer complicadas redefinições em termos do número de possibilidades.

Nesta seção nós apresentamos a hipótese de que as leis probabilísticas da física quântica podem ser um sinal da presença de vida no interior dos átomos. Na primeira metade do século XX a teoria quântica introduziu leis probabilísticas para descrever os movimentos das partículas atômicas. Estas leis probabilísticas comprovadas podem ser uma indicação de que o mundo atômico é muito mais complexo do que nós presentemente acreditamos. É possível que exista vida e um padrão de "sistema solar" dentro do átomo, e que estas leis probabilísticas sejam uma espécie de estatística deste mundo atômico complexo.

No século XIX, devido ao grande sucesso da física clássica, alguns indivíduos acreditavam que nós estamos vivendo em um mundo determinístico. Para eles, se nos for dado a possibilidade de conhecer a posição inicial e a velocidade de todos os corpos materiais do universo, nós poderemos prever todos os movimentos e estados futuros de todas as coisas. De fato isso aconteceu em certa extensão aos corpos astronômicos. Uma extensão natural desta forma de pensar é acreditar que isso acontece também em uma escala atômica. Mas inúmeros experimentos comprovaram fatos físicos, como a radiação do corpo negro, o efeito fotoelétrico, o espectro óptico do hidrogênio, e as propriedades ondulatórias dos elétrons, que indicam uma realidade diferente nos átomos. Conceitos, como o da quantização de energia, e o da dualidade partícula-onda da matéria e radiação, culminaram com a famosa equação de onda de Schroedinger [6] e a interpretação probabilística destas equações. Partículas foram descritas pelas equações de campo e os valores do campo em uma certa posição indicam a probabilidade da partícula de estar nesta posição. Assim se atribuí um valor probabilístico, ao invés de um valor determinístico, para a posição e o momento, para o tempo e a energia, e para as quantidades físicas derivadas destas.

Estas leis probabilísticas foram provadas por experimentos mais refinados, que se tornaram possíveis com o desenvolvimento tecnológico. Mas é um problema em aberto o motivo de porque estas leis probabilísticas existem. Alguns indivíduos podem acreditar que as partículas atômicas são como dados de um jogo probabilístico. Outros podem acreditar que o mundo atômico é tão complexo como a sociedade humana e que as leis probabilísticas são uma espécie de estatística desta complexidade integrada. De fato, um grande número de partículas atômicas foi descrito nos aceleradores de partículas. Também, no ramo da física teórica, seis novas dimensões espaciais compactadas, três dimensões espaciais extendidas, e o tempo, parecem compor uma física de 10 dimensões, nas teorias das supercordas, que apresentam uma explicação unificada dos campos de força e das partículas do universo. Assim, experimentalmente e teoricamente, a complexidade do universo aumentou. Esta complexidade pode explicar as observações e leis probabilísticas da física quântica.

Mas como vimos através de todo este artigo, organização, probabilidade e complexidade é uma marca da vida. Devido ao fato, dos estados e movimentos dos organismos vivos serem complexos e probabilísticos, nós os chamamos de sinais vitais, e mostramos em que sentido eles são cheios de informação. Os sistemas simples e determinísticos, que são descritos em equações matemáticas exatas, contêm menos informação. Os estados e movimentos destes sistemas são chamados de sinais determinísticos. Devido ao fato, das leis probabilísticas e estatísticas serem as que descrevem os estados e movimentos da vida, nós estamos dizendo aqui, que as leis probabilísticas da física de escalas atômicas, talvez possam ser explicadas pela presença de vida no interior dos átomos. Para provar esta hipótese, vai ser necessário entender o comportamento macroscópico da vida. O estudo do todo universal será importante para entender cada parte individual deste universo, se de alguma forma a semente do todo estiver no centro de cada parte não-divisível, cada parte a-tômica4 deste todo universal. Este estudo pode estimular uma abordagem mais multidisciplinar e holística nos aprendizes da escola da vida.

É razoável concluir que o universo não é nem meramente mecânico, nem mágico; ele é uma criação da mente e um mecanismo com leis. E acima da mente criadora vive o espírito do criador. Estaremos sendo mecanicistas se insistirmos em ver como um acaso a criação material e a evolução humana. Não é racional esquecer a Mente Infinita do Criador caso não consigamos explicar deterministicamente os movimentos intra-atômicos que descrevemos parcialmente com as leis probabilísticas da física quântica. Tenho certeza que Albert Einstein ficaria feliz em saber da influência da infinitude estática do Absoluto Inqualificável no movimento das partículas no interior dos átomos. Como revelado no bendito:

"Livro de Urantia", parágrafo 42.7_10: Os primeiros vinte e sete átomos, aqueles que contêm de um a vinte e sete elétrons em órbita, são mais fáceis de serem distinguidos do que os restantes. Do vigésimo-oitavo, em diante, encontramos cada vez mais a imprevisibilidade da presença suposta do Absoluto Inqualificável. Um pouco dessa imprevisibilidade eletrônica, todavia, é causada pelas velocidades axiais das rotações ultimatômicas diferenciais e pela propensão inexplicada dos ultímatons de "amontoarem-se". Outras influências - físicas, elétricas, magnéticas e gravitacionais - também colaboram para produzir comportamentos eletrônicos variáveis. Os átomos são, pois, semelhantes a pessoas quanto à previsibilidade. Os estatísticos podem anunciar leis que governam um grande número, seja de átomos, seja de pessoas; mas não individualmente para um único átomo, nem para uma única pessoa.